Cerebras llança la inferència de IA més ràpida del món

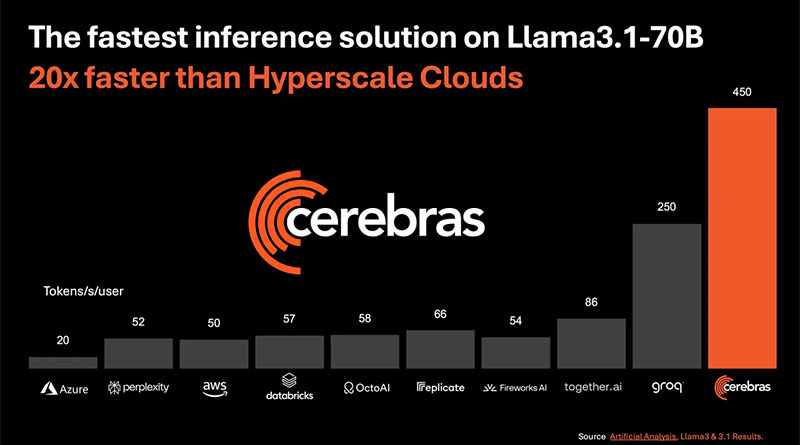

Cerebras Systems, una empresa pionera en l’àmbit de la computació d’alt rendiment per a intel·ligència artificial (IA), ha llançat la seva solució més recent: Cerebras Inference, un sistema que promet ser el més ràpid del món en l’execució d’inferències d’IA. Aquest nou sistema ofereix una velocitat sorprenent, processant fins a 1.800 tokens per segon per al model Llama3.1 8B i 450 tokens per segon per al model Llama3.1 70B, cosa que el posiciona 20 vegades més ràpid que les solucions basades en GPU de NVIDIA en núvols a gran escala.

Velocitat sense precedents i precisió mantinguda

Una de les característiques més destacades de Cerebras Inference és la seva capacitat per mantenir una alta precisió en les inferències, aconseguint resultats dins del domini de 16 bits al llarg de tota l’execució, sense comprometre la precisió en favor del rendiment. Això és particularment rellevant ja que, en comparació amb altres solucions, l’oferta de Cerebras no només és més ràpida sinó que també garanteix una exactitud en el processament que respecta els estàndards més alts de qualitat.

Un rendiment 20 vegades superior

Segons declaracions de Micah Hill-Smith, cofundador i CEO d’Artificial Analysis, Cerebras Inference ha superat significativament les solucions basades en GPU en els benchmarks d’inferència d’IA per als models Llama 3.1 de Meta. Les medicions realitzades demostren que el sistema de Cerebras arriba a més de 1.800 tokens per segon en Llama 3.1 8B i més de 446 tokens per segon en Llama 3.1 70B, establint un nou rècord en aquests indicadors de rendiment.

Un canvi de paradigma en la inferència d’IA

El sector de la inferència d’IA és el de major creixement dins del mercat de maquinari per a intel·ligència artificial, representant aproximadament el 40% del total. La capacitat de processar més de 1.000 tokens per segon marca un fita comparable a la introducció de l’internet de banda ampla, alliberant noves oportunitats i anunciant una nova era per a les aplicacions d’IA. Amb una velocitat 20 vegades superior a les solucions tradicionals, Cerebras Inference permet als desenvolupadors construir aplicacions d’IA de pròxima generació, que requereixen un rendiment en temps real complex i de múltiples etapes, com ara els agents d’IA.

Preus competitius i opcions d’accés

Cerebras ha estructurat el seu servei d’inferència en tres nivells amb preus altament competitius:

- Free Tier: Proporciona accés gratuït a l’API amb límits d’ús generosos, disponible per a qualsevol usuari registrat.

- Developer Tier: Dissenyat per a desplegaments flexibles i sense servidor, aquest nivell ofereix un punt final API a una fracció del cost de les alternatives del mercat. Els models Llama 3.1 8B i 70B estan disponibles a 10 i 60 cèntims per milió de tokens, respectivament.

- Enterprise Tier: Ofereix models afinats, acords de nivell de servei personalitzats i suport dedicat, ideal per a càrregues de treball contínues. Les empreses poden accedir al servei d’inferència de Cerebras a través d’un núvol privat gestionat o a les instal·lacions del client, amb preus disponibles a sol·licitud.

Associacions estratègiques per al desenvolupament de l’IA

El desenvolupament d’aplicacions d’IA requereix un conjunt divers d’eines especialitzades en cada etapa, des de models de codi obert fins a frameworks que permeten un desenvolupament ràpid, com LangChain i LlamaIndex. Cerebras està col·laborant amb líders de la indústria com Docker, Nasdaq, Weights & Biases, Weaviate, AgentOps i Log10, per impulsar el futur de la IA.

Aquestes associacions estratègiques reforcen la posició de Cerebras Inference com una solució integral per als desenvolupadors que busquen potenciar aplicacions d’IA amb capacitats avançades i temps de resposta ultra ràpids.

Suport tècnic de vanguardia

El sistema Cerebras CS-3 impulsa aquesta solució d’inferència, utilitzant el processador d’IA més avançat del món, el Wafer Scale Engine 3 (WSE-3). A diferència de les unitats de processament gràfic (GPU), que obliguen els usuaris a comprometre’s entre velocitat i capacitat, el CS-3 ofereix el millor rendiment per usuari al temps que garanteix un alt rendiment general. Amb un ample de banda de memòria 7.000 vegades superior al Nvidia H100, el WSE-3 resol el desafiament tècnic fonamental de la IA generativa: l’ample de banda de memòria.

Accés i compatibilitat

Els desenvolupadors poden accedir fàcilment a l’API d’inferència de Cerebras, que és totalment compatible amb l’API d’OpenAI Chat Completions, cosa que permet una migració sense problemes amb només unes poques línies de codi.

L’impacte de la velocitat en l’adopció de l’IA

Numerosos líders en IA han expressat el seu entusiasme per les capacitats de Cerebras Inference. Per exemple, Kim Branson, vicepresident sènior d’IA/ML a GlaxoSmithKline, va destacar que “la velocitat i l’escala ho canvien tot“, subratllant com les millores en la velocitat poden revolucionar les aplicacions d’IA.

Russell D’sa, CEO i cofundador de LiveKit, va mencionar com la combinació de les capacitats de càlcul de Cerebras i els models d’última generació amb la xarxa global de LiveKit permet crear experiències d’IA multimodals amb latència ultra baixa i característiques més humanes.

En l’àmbit dels motors de cerca, Denis Yarats, CTO i cofundador de Perplexity, va assenyalar que les velocitats d’inferència ultra ràpides com les que demostra Cerebras poden canviar la manera en què els usuaris interactuen amb les futures plataformes de cerca intel·ligent.

Finalment, Anil Varanasi, CEO de Meter, va comentar sobre la importància de la velocitat en la infraestructura, afirmant que el rendiment de Cerebras Inference millora la capacitat de Meter Command per generar programari personalitzat i prendre accions amb la mateixa facilitat i rapidesa amb què es fan cerques a la web.

Cerebras Inference es posiciona com una solució revolucionària en el camp de la inferència d’IA, oferint una combinació única de velocitat, precisió i escalabilitat. Amb la seva capacitat per superar significativament les ofertes basades en GPU i el seu enfocament en mantenir la precisió sense compromisos, Cerebras Systems està empenyent els límits del possible en el desenvolupament d’aplicacions d’IA. Les seves associacions estratègiques i el seu model de preus competitiu reforcen la seva posició com a líder en aquest camp en ràpida evolució.

Amb aquesta nova tecnologia, Cerebras no només està oferint una millora incremental, sinó que està transformant fonamentalment com es realitza la inferència d’IA, obrint la porta a noves possibilitats per a desenvolupadors i empreses a tot el món.o fundamentalmente cómo se realiza la inferencia de IA, abriendo la puerta a nuevas posibilidades para desarrolladores y empresas en todo el mundo.