Llama 3.2: Revolucionant la IA i la Visió d’Avantguarda amb Models Oberts i Personalitzables

La Intel·ligència Artificial (IA) avança ràpidament, i amb cada nova versió, les barreres tecnològiques es desplomen, permetent més innovació i accessibilitat. Meta ha estat una de les principals impulsores d’aquesta revolució, i amb el llançament de Llama 3.2, estem davant d’un milestone que canvia les regles del joc. Aquest article aprofundeix en els detalls de Llama 3.2, les seves capacitats, el seu ecosistema, i com està transformant la IA amb models més oberts, personalitzables i eficients.

Introducció a Llama 3.2

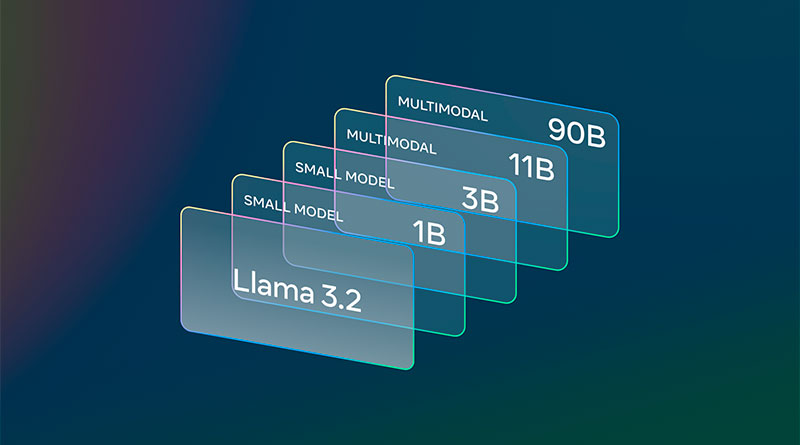

Llama 3.2 és la nova versió dels models de llenguatge de gran mida (LLM) que Meta ha desenvolupat per oferir una major flexibilitat i rendiment tant en processament de llenguatge com en comprensió visual. Aquesta versió inclou models més lleugers, dissenyats per funcionar en dispositius mòbils i de gamma alta, així com models de visió capaços de realitzar tasques avançades de comprensió d’imatges. A més, Meta ha facilitat la seva descàrrega i desenvolupament immediat en un ampli ecosistema de plataformes tecnològiques, reafirmant el seu compromís amb l’obertura i la col·laboració.

Què Fa Que Llama 3.2 Sigui Diferent?

Els models de Llama 3.2, especialment els més lleugers com el 1B i el 3B, estan dissenyats per operar en dispositius mòbils, mantenint la privadesa en processar dades de manera local. Això significa que les aplicacions que utilitzen aquests models poden funcionar sense dependre del núvol, la qual cosa millora tant la velocitat de processament com la seguretat de les dades personals.

Pel que fa als models més grans, com el 11B i el 90B, la novetat rau en la seva capacitat per comprendre imatges i realitzar tasques de raonament visual. Aquesta habilitat converteix Llama 3.2 en una eina multimodal versàtil que pot gestionar tant text com imatges, obrint la porta a aplicacions més sofisticades, des de subtitulat automàtic fins a anàlisi de dades visuals complexes.

Llama 3.2: Potencial i Abast

Models Lleugers per al Processament Local

Un dels aspectes més destacats de Llama 3.2 és la introducció de models lleugers com el 1B i el 3B. Aquests models estan optimitzats per operar en dispositius amb capacitat limitada, com smartphones i tablets, però sense sacrificar la potència ni el rendiment. Gràcies a l’arquitectura de processament local, aquests models poden executar tasques com resums de text, seguiment d’instruccions i generació multilingüe sense dependre de connexions externes.

L’avantatge de tenir el processament directament al dispositiu és doble: d’una banda, es redueix la latència, ja que les respostes són pràcticament instantànies, i de l’altra, s’garanteix la privadesa de les dades, un aspecte cada vegada més important en l’entorn actual. Aquests models, per tant, són ideals per a aplicacions on la seguretat i la rapidesa són clau.

Models de Visió: Un Nou Horitzó per a la IA

Llama 3.2 no s’atura en el processament de llenguatge. Els seus models de visió, com el 11B i el 90B, permeten que la IA no només interpreti text, sinó també imatges. Això obre un sense fi de possibilitats en àrees com l’anàlisi visual, el subtitulat automàtic d’imatges, la interpretació de gràfics i la localització d’objectes.

Imagina una eina que pot analitzar una imatge d’un gràfic financer i, basant-se en la informació visual, oferir una interpretació textual del rendiment d’una empresa al llarg del temps. O pensa en una IA que pugui interpretar un mapa i respondre preguntes com “quan es torna més empinada la caminada en aquesta ruta?”. Aquest tipus d’aplicacions són possibles gràcies a la capacitat de raonament visual de Llama 3.2.

Ecosistema de Desenvolupament de Llama 3.2

Llama Stack: Simplificació per als Desenvolupadors

Per facilitar l’adopció i el desenvolupament sobre Llama 3.2, Meta ha llançat Llama Stack, un conjunt d’eines i biblioteques dissenyades per integrar sense problemes aquests models en diverses aplicacions. Amb una estreta integració amb biblioteques PyTorch, Llama Stack ofereix als desenvolupadors la possibilitat d’ajustar i personalitzar els models segons les seves necessitats específiques. A més, la compatibilitat amb plataformes com Qualcomm, MediaTek i processadors ARM permet que els models lleugers s’executin en una àmplia gamma de dispositius mòbils.

Llama Stack no només simplifica el procés de desenvolupament, sinó que també facilita l’ajustament fi dels models per a aplicacions personalitzades. Ja sigui que treballis al núvol, en dispositius locals o en servidors on-prem, Llama Stack proporciona un entorn coherent i estandarditzat que agilita el procés d’implementació.

Col·laboracions i Socis Clau

El llançament de Llama 3.2 no hauria estat possible sense la col·laboració d’importants socis tecnològics. Empreses com AWS, Databricks, Google Cloud, IBM, Intel i NVIDIA han treballat juntament amb Meta per optimitzar la implementació d’aquests models. Aquestes col·laboracions garanteixen que els desenvolupadors puguin accedir a una infraestructura robusta i fiable per desplegar aplicacions basades en IA en diferents entorns.

A més, Meta ha treballat estretament amb Qualcomm i MediaTek per garantir que els models lleugers funcionin de manera eficient en dispositius mòbils, la qual cosa demostra un enfocament integral per portar la IA d’avantguarda a més persones a tot el món.

Avaluació i Rendiment de Llama 3.2

Comparativa amb Altres Models de IA

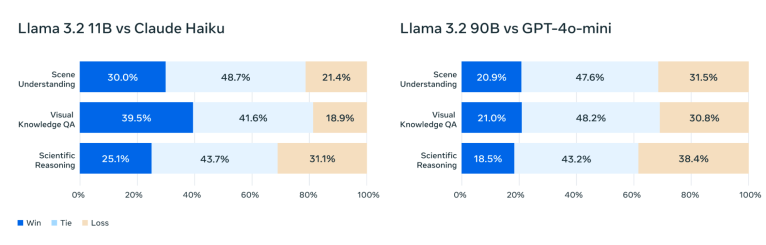

Una de les principals preguntes al valorar qualsevol nou model de IA és: com es compara amb la competència? En aquest cas, Llama 3.2 ha demostrat estar a l’alçada dels principals models tancats del mercat, com Claude 3 Haiku i GPT4o-mini, especialment en tasques de comprensió visual. En proves exhaustives, els models de visió de Llama han superat altres models de base en el reconeixement d’imatges i en tasques de raonament visual.

Fins i tot els models lleugers, com el 3B, han demostrat la seva vàlua davant competidors com Gemma 2 i Phi 3.5-mini, destacant-se en tasques com el seguiment d’instruccions i l’ús d’eines. Aquest alt rendiment, combinat amb l’avantatge de ser models oberts, fa de Llama 3.2 una opció molt atractiva per a desenvolupadors que busquen flexibilitat sense sacrificar capacitat.

Seguretat i Responsabilitat

Meta ha prioritzat la seguretat en el desenvolupament de Llama 3.2, implementant una sèrie de salvaguardes dissenyades per garantir que els models siguin utilitzats de manera responsable. Això inclou el llançament de Llama Guard 3, una eina que filtra sol·licituds i respostes que impliquin text i imatges per evitar resultats no desitjats. A més, Llama 3.2 ha estat entrenat amb dades de mitigació de seguretat per assegurar-se que els models siguin robusts davant intents de manipulació.

Models de Llama 3.2 Disponibles

Llama 3.2 a Hugging Face i Llama.com

Llama 3.2 ja està disponible per a la seva descàrrega a llama.com i Hugging Face, la qual cosa facilita als desenvolupadors accedir a aquests potents models. A més, les versions optimitzades per a dispositius mòbils estan disponibles per desenvolupar-se immediatament, obrint un ventall de possibilitats per a la creació d’aplicacions en el bord.

El suport de plataformes com AWS, Google Cloud, i Microsoft Azure garanteix que els desenvolupadors puguin desplegar aplicacions basades en Llama 3.2 en entorns empresarials a gran escala, mentre que les col·laboracions amb Qualcomm i MediaTek asseguren que fins i tot els dispositius mòbils d’última generació puguin beneficiar-se de les capacitats avançades d’IA que ofereix Llama 3.2.

Preguntes Freqüents

Què és Llama 3.2?

Llama 3.2 és l’última versió dels models de llenguatge grans (LLM) de Meta, que inclou models lleugers per a processament en dispositius mòbils i models de visió per a tasques avançades de comprensió d’imatges.

Com millora Llama 3.2 en dispositius mòbils?

Els models 1B i 3B estan optimitzats per operar localment en dispositius mòbils, la qual cosa garanteix una major privadesa i respostes més ràpides, ja que no depenen del núvol per processar dades.

Què és Llama Stack?

Llama Stack és un conjunt d’eines i biblioteques integrades que simplifiquen el desenvolupament i la personalització dels models Llama 3.2, permetent la seva implementació en diversos entorns, com el núvol o dispositius locals.

Quines capacitats tenen els models de visió de Llama 3.2?

Els models de visió de Llama 3.2, com el 11B i el 90B, poden realitzar tasques avançades de raonament visual, com l’anàlisi de gràfics i mapes, el subtitulat d’imatges i la localització d’objectes a partir de descripcions textuals.

Com es compara Llama 3.2 amb altres models de IA?

Llama 3.2 ha demostrat ser competitiu amb models tancats com Claude 3 Haiku i GPT4o-mini, especialment en tasques de comprensió visual i raonament d’imatges.

On puc descarregar Llama 3.2?

Llama 3.2 està disponible per a la seva descàrrega a llama.com i Hugging Face, i pot desenvolupar-se en una àmplia gamma de plataformes tecnològiques, incloent AWS, Google Cloud i Microsoft Azure.

Conclusió

Llama 3.2 està marcant un nou estàndard en l’evolució de la IA oberta, permetent a més desenvolupadors i empreses accedir a eines avançades que anteriorment només estaven disponibles en entorns tancats i costosos. Amb la seva capacitat per processar text i imatges, models lleugers per a dispositius mòbils i un ecosistema robust de socis tecnològics, Llama 3.2 està preparat per transformar la manera com es desenvolupen i utilitzen les aplicacions d’IA. L’obertura i la personalització són el futur, i Llama 3.2 està a l’avantguarda d’aquesta revolució.