Qwen2.5-Coder: Nou estàndard en LLMs de codi

Avui s’ha anunciat l’obertura de la sèrie Qwen2.5-Coder, una gamma de models de codi obert amb capacitats poderoses, diverses i pràctiques per al desenvolupament de LLMs especialitzats en codi.

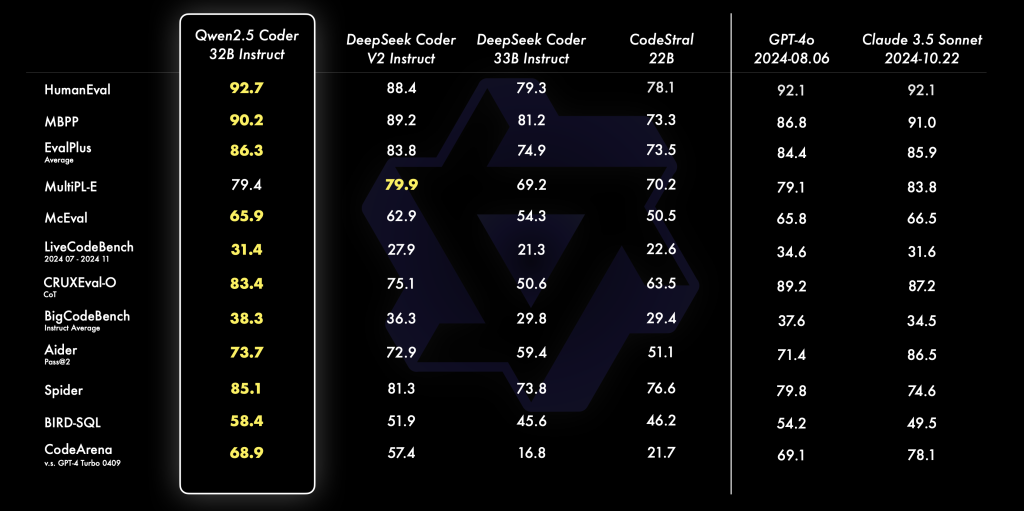

Poderós: El model Qwen2.5-Coder-32B-Instruct és ara el model de codi obert líder en el sector, igualant les habilitats de GPT-4o en generació i reparació de codi, amb solidesa en tasques de raonament i matemàtiques. Destaca en els principals benchmarks de generació de codi, com EvalPlus i LiveCodeBench, demostrant ser una eina robusta per a desenvolupadors que busquen suport en múltiples llenguatges.

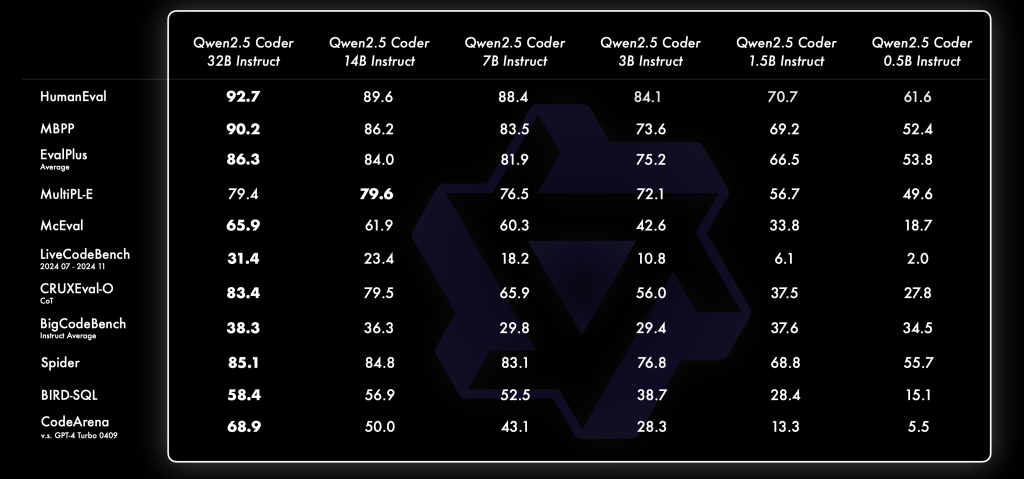

Divers: Amb aquesta versió, Qwen2.5-Coder amplia les seves opcions amb sis mides de model (0.5B a 32B), cosa que el converteix en una opció adaptable a diverses necessitats i recursos. Això permet als desenvolupadors escollir models que s’ajustin als seus requisits, ja sigui en entorns de prova o en aplicacions més complexes.

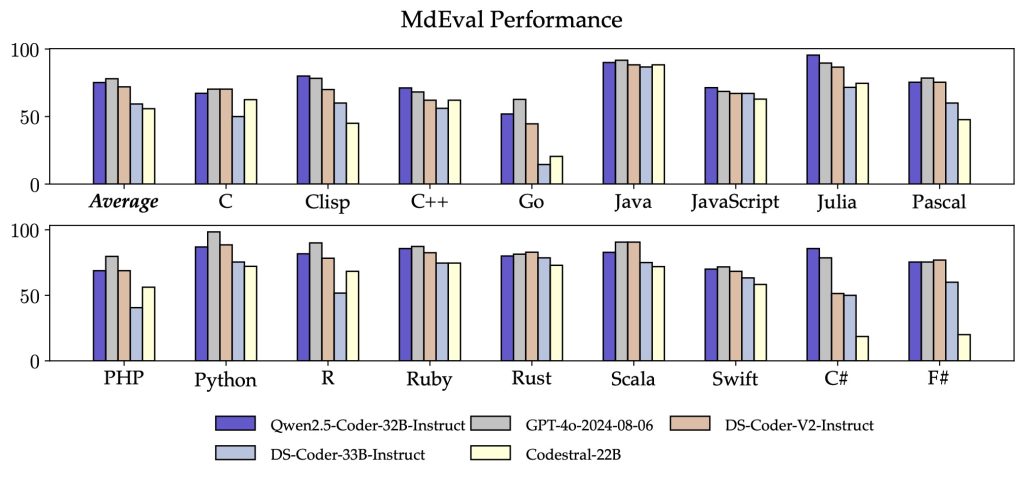

Pràctic: Qwen2.5-Coder mostra la seva utilitat en entorns reals, especialment com a assistent de codi i en la generació d’artefactes. El seu rendiment en tasques de reparació de codi és excel·lent, obtenint una puntuació de 73.7 en el benchmark Aider, gairebé al nivell de GPT-4o, i amb suport per a més de 40 llenguatges de programació, superant altres models en avaluació multillenguatge amb una puntuació de 75.2 a MdEval.

En termes d’alineació amb preferències humanes, Qwen2.5-Coder ha estat avaluat en la plataforma interna Code Arena, on la seva alineació de respostes amb expectatives humanes ha destacat en comparació amb GPT-4o. Això avala la seva utilitat com a assistent de programació fiable, tant en la generació de nou codi com en l’adaptació de fragments existents.

Varietat d’opcions de mida de model: La disponibilitat de mides de 0.5B, 1.5B, 3B, 7B, 14B i 32B permet que Qwen2.5-Coder s’utilitzi en entorns amb diferents recursos. En avaluacions internes, s’ha demostrat una correlació positiva entre la mida del model i el seu rendiment, posicionant Qwen2.5-Coder com un dels models més adaptables i competitius en codi obert.

| Models | Paràmetres | Paràmetres sense emb | Capes | Llargada de context | Llicència |

|---|---|---|---|---|---|

| Qwen2.5-Coder-0.5B | 0.49B | 0.36B | 24 | 32K | Apache 2.0 |

| Qwen2.5-Coder-1.5B | 1.54B | 1.31B | 28 | 32K | Apache 2.0 |

| Qwen2.5-Coder-3B | 3.09B | 2.77B | 36 | 32K | Qwen Research |

| Qwen2.5-Coder-7B | 7.61B | 6.53B | 28 | 128K | Apache 2.0 |

| Qwen2.5-Coder-14B | 14.7B | 13.1B | 48 | 128K | Apache 2.0 |

| Qwen2.5-Coder-32B | 32.5B | 31.0B | 64 | 128K | Apache 2.0 |

Entorns pràctics: Cursor i Artifacts: Qwen2.5-Coder s’ha optimitzat per funcionar com a assistent de codi en la plataforma Cursor i per a la generació d’artefactes o projectes visuals, com simulacions complexes. A més, estarà disponible pròximament al web oficial de Tongyi, permetent la creació de llocs web, mini-jocs i gràfics de dades amb un sol clic.

Llicències i disponibilitat: Els models de Qwen2.5-Coder estan disponibles sota llicències Apache 2.0 i Qwen-Research (per al model 3B), garantint accés obert i ús adaptatiu per a la comunitat.

Plans de futur: L’equip de Qwen-Coder continuarà desenvolupant models enfocats en el raonament i l’alineació amb preferències humanes, buscant proporcionar eines més potents per a desenvolupadors d’arreu del món.

Preguntes i Respostes sobre Qwen2.5-Coder

Què és Qwen2.5-Coder?

Qwen2.5-Coder és un model de llenguatge especialitzat en programació de codi obert, desenvolupat per oferir suport en generació i reparació de codi en múltiples llenguatges.

Quines capacitats té Qwen2.5-Coder-32B?

Qwen2.5-Coder-32B posseeix capacitats avançades en generació, reparació i raonament de codi, amb rendiments comparables als de GPT-4o.

Quantes mides de model ofereix Qwen2.5-Coder?

Ofereix sis mides de model (0.5B a 32B), adaptant-se a diferents recursos i necessitats dels desenvolupadors.

On es pot utilitzar Qwen2.5-Coder?

Es pot utilitzar com a assistent de codi en la plataforma Cursor i en la generació d’artefactes visuals en aplicacions com Open WebUI i Tongyi.