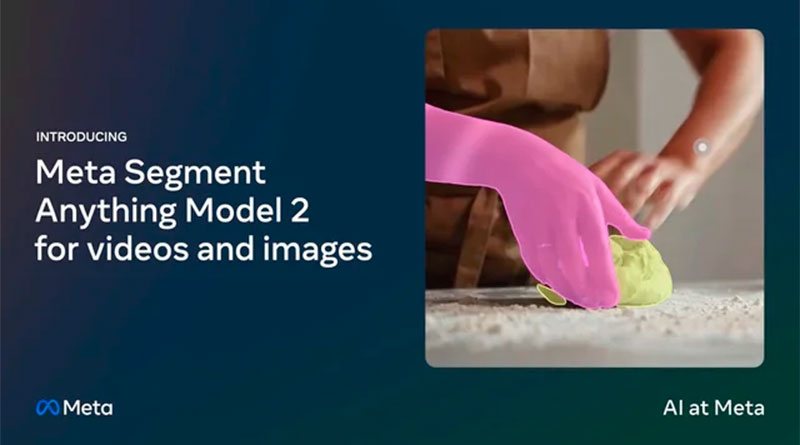

Meta Segment Anything Model 2 – SAM 2

Meta ha llançat SAM 2, la nova generació del seu model de segmentació d’objectes, capaç de treballar amb imatges i vídeos en temps real. Aquest model unificat permet la segmentació precisa i ràpida sense necessitat d’adaptacions personalitzades, obrint una varietat d’aplicacions pràctiques en ciència, medicina, creació de continguts i més. SAM 2 destaca per la seva capacitat de generalització de zero-shot, millorant significativament el rendiment en comparació amb models anteriors i reduint el temps d’interacció humana en tres vegades.

El model es presenta amb el conjunt de dades SA-V, que inclou aproximadament 51,000 vídeos i més de 600,000 “masklets” (màscares espaciotemporals). Aquest conjunt de dades és 4.5 vegades més gran i té 53 vegades més anotacions que els conjunts de dades existents. L’obertura del codi i els pesos del model sota la llicència Apache 2.0 fomenta la investigació i el desenvolupament obert, permetent a la comunitat explorar noves capacitats i casos d’ús.

Característiques principals de SAM 2:

1. Segmentació d’objectes en imatges i vídeos:

- SAM 2 supera les capacitats anteriors en precisió de segmentació d’imatges i rendiment en vídeos.

- Es requereix un terç del temps d’interacció per aconseguir resultats comparables als models anteriors.

- Capaç de segmentar qualsevol objecte en qualsevol vídeo o imatge sense adaptació personalitzada.

2. Avanços en l’arquitectura:

- L’arquitectura SAM 2 generalitza d’imatges a vídeos, utilitzant un mecanisme de memòria per recordar informació prèvia i millorar la segmentació al llarg del temps.

- La inclusió d’un mòdul d’atenció a la memòria permet una segmentació precisa en cada quadre del vídeo, fins i tot en escenaris d’oclusió o desaparició de l’objecte.

3. Dataset SA-V:

- Amb més de 600,000 anotacions de masklets en aproximadament 51,000 vídeos, cobrint una àmplia diversitat geogràfica i situacions del món real.

- Inclou tant objectes complets com parts d’objectes i situacions desafiants on els objectes es oculten, desapareixen i reapareixen.

4. Aplicacions potencials:

- Creació d’efectes de vídeo, edició de vídeo, i aplicacions científiques com el seguiment de cèl·lules en vídeos microscòpics.

- Eines d’anotació més ràpides per a dades visuals, millorant sistemes de visió per ordinador en vehicles autònoms i altres tecnologies.

- Noves formes de seleccionar i interactuar amb objectes en temps real o en vídeos en viu.

5. Interactivitat i precisió:

- La capacitat de SAM 2 per manejar l’ambigüitat al generar múltiples màscares en cada pas del vídeo i permetre la refinació iterativa a través d’interaccions addicionals.

- Millores en el seguiment d’objectes malgrat els canvis dràstics en el punt de vista de la càmera, oclusions prolongades, i escenes concorregudes.

SAM 2 representa un salt qualitatiu en la tecnologia de segmentació d’objectes, unificant el processament d’imatges i vídeos amb una precisió i velocitat sense precedents. La col·laboració oberta i la disponibilitat de recursos permeten a la comunitat d’IA explorar noves fronteres en la segmentació visual, obrint un ventall de possibilitats per a innovacions futures.