Meta, anuncia Llama 3

S’anuncien els dos primers models de la pròxima generació de Llama, Meta Llama 3, disponibles per a un ús ampli. Aquesta versió inclou models de llenguatge preentrenats i ajustats amb instruccions de 8B i 70B de paràmetres que poden suportar una àmplia gamma de casos d’ús. Aquesta nova generació de Llama demostra un rendiment d’avantguarda en una àmplia gamma de referències de la indústria i ofereix noves capacitats, incloent-hi un raonament millorat. Es considera que aquests són els millors models de codi obert de la seva classe. En suport a un enfocament obert de llarg termini, Llama 3 es posa en mans de la comunitat. Es busca impulsar la pròxima ona d’innovació en IA en tot l’espectre, des d’aplicacions fins a eines de desenvolupament, avaluacions i optimitzacions d’inferència. Hi ha un gran interès a veure el que es construirà i s’esperen comentaris.

Objectius per a Llama 3: L’objectiu amb Llama 3 va ser construir els millors models oberts que estiguin a l’una amb els millors models propietaris disponibles avui. Es va voler abordar els comentaris dels desenvolupadors per a augmentar la utilitat general de Llama 3 i s’està fent això mentre es continua exercint un paper líder en l’ús i desplegament responsable de LLMs. S’adopta el ethos de codi obert de llançar primerenc i sovint perquè la comunitat pugui accedir a aquests models mentre encara estan en desenvolupament.

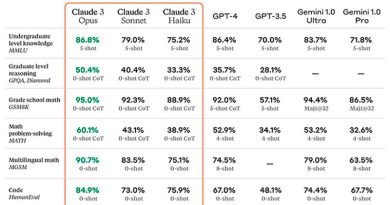

Rendiment d’avantguarda: Els nous models Llama 3 de 8B i 70B de paràmetres són un gran avanç sobre Llama 2 i estableixen un nou estàndard per als models LLM en aquestes escales. Gràcies a les millores en el preentrenament i l’ajust posterior, els models preentrenats i ajustats amb instruccions són els millors models existents avui en l’escala de 8B i 70B de paràmetres. Les millores en els procediments posteriors a l’entrenament van reduir substancialment les taxes de rebuig fals, van millorar l’alineació i van incrementar la diversitat en les respostes del model.

Desenvolupament de Llama 3: En el desenvolupament de Llama 3, es va examinar el rendiment del model en referències estàndard i també es va buscar optimitzar el rendiment per a escenaris del món real. Per a això, es va desenvolupar un nou conjunt d’avaluació humana d’alta qualitat. Aquest conjunt d’avaluació conté 1800 indicacions que cobreixen 12 casos d’ús clau. Per a evitar el sobre ajust accidental dels models en aquest conjunt d’avaluació, fins i tot els mateixos equips de modelatge no tenen accés a ell.

Arquitectura del model: En línia amb la filosofia de disseny adoptada, es va optar per una arquitectura de transformador sol descodificador relativament estàndard en Llama 3. En comparació amb Llama 2, es van fer diverses millores clau. Llama 3 utilitza un tokenitzador amb un vocabulari de 128K tokens que codifica el llenguatge de manera molt més eficient, la qual cosa porta a una millora substancial en el rendiment del model.

Dades d’entrenament: Per a entrenar el millor model de llenguatge, la curació d’un gran conjunt de dades d’entrenament d’alta qualitat és primordial. Llama 3 es preentrena en més de 15T tokens recopilats de fonts públicament disponibles. El conjunt de dades d’entrenament és set vegades més gran que el fet servir per a Llama 2, i inclou quatre vegades més codi.

Afinació fina d’instruccions: Per a aprofitar completament el potencial dels models preentrenats en casos d’ús de xat, es va innovar en l’enfocament per a l’afinació fina d’instruccions. L’enfocament per a l’entrenament posterior és una combinació d’afinació supervisada (SFT), mostreig de rebuig, optimització de polítiques proximals (PPO) i optimització de polítiques directes (DPO).

Amb Llama 3, s’estan proporcionant noves eines de confiança i seguretat, incloent-hi components actualitzats amb Llama Guard 2 i Cybersec Eval 2, i la introducció de Code Shield, un guàrdia de temps d’inferència per a filtrar codi insegur produït.