Veu realista de GPT-4o en versió alfa

OpenAI ha començat a implementar el Mode de Veu Avançada de ChatGPT, oferint als usuaris accés a les respostes d’àudio hiperrealistes de GPT-4o. La versió alfa estarà disponible avui per a un petit grup de subscriptors de ChatGPT Plus, i OpenAI afirma que la funció es desplegarà gradualment a tots els usuaris Plus a la tardor de 2024.

Detalls de la veu hiperrealista en versió alfa només per a alguns usuaris.

Impacte Inicial i Controvèrsies

Quan OpenAI va presentar per primera vegada la veu de GPT-4o al maig, la funció va sorprendre el públic amb respostes ràpides i una sorprenent semblança a la veu humana. Una veu en particular, anomenada Sky, s’assemblava a la de Scarlett Johansson, l’actriu darrere de l’assistent artificial a la pel·lícula “Her”. Després de la demostració, Johansson va declarar que havia rebutjat múltiples sol·licituds del CEO d’OpenAI, Sam Altman, per utilitzar la seva veu, i, després de veure la demo, va contractar assessorament legal per defensar la seva imatge. Tot i que OpenAI va negar haver utilitzat la veu de Johansson, posteriorment va eliminar la veu mostrada a la demostració. Al juny, OpenAI va anunciar que retardaria el llançament del Mode de Veu Avançada per millorar les seves mesures de seguretat.

Característiques del Mode de Veu Avançada

El Mode de Veu Avançada difereix significativament del mode de veu prèviament disponible a ChatGPT. Anteriorment, ChatGPT utilitzava tres models separats per convertir la veu a text, processar el missatge amb GPT-4 i després convertir el text de ChatGPT en veu. No obstant això, GPT-4o és multimodal, capaç de realitzar aquestes tasques sense l’ajuda de models auxiliars, cosa que crea converses amb una latència significativament menor. OpenAI també afirma que GPT-4o pot detectar entonacions emocionals a la veu de l’usuari, incloent-hi tristesa, emoció o fins i tot cant.

Experiència d’Usuari i Seguretat

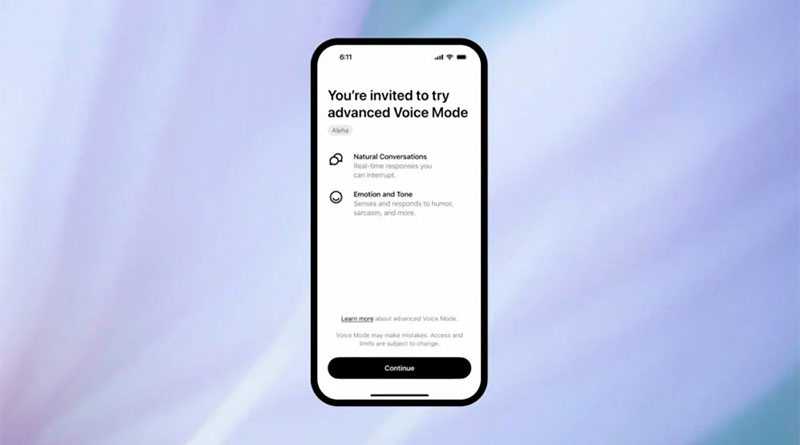

En aquesta fase pilot, els usuaris de ChatGPT Plus podran experimentar de primera mà el hiperrealista que és el Mode de Veu Avançada d’OpenAI. OpenAI diu que està llançant gradualment la nova veu de ChatGPT per monitorar de prop el seu ús. Les persones en el grup alfa rebran una alerta a l’aplicació de ChatGPT, seguida d’un correu electrònic amb instruccions sobre com utilitzar la nova funció.

Control de Veu i Evitació de Controvèrsies

El Mode de Veu Avançada estarà limitat a les quatre veus preestablertes de ChatGPT: Juniper, Breeze, Cove i Ember, creades en col·laboració amb actors de veu pagats. La veu Sky mostrada a la demostració de maig ja no està disponible a ChatGPT. Lindsay McCallum, portaveu d’OpenAI, va declarar que “ChatGPT no pot imitar les veus d’altres persones, tant individus com figures públiques, i bloquejarà les sortides que difereixin d’una d’aquestes veus preestablertes”.

Futur del Mode de Veu Avançada

OpenAI planeja expandir l’accés a més usuaris de ChatGPT Plus en les pròximes setmanes, amb un llançament complet per a tots els subscriptors Plus previst per aquesta tardor. Aquesta expansió permetrà que més usuaris experimentin i proporcionin retroalimentació sobre aquesta innovadora funció, ajudant a OpenAI a millorar i perfeccionar el Mode de Veu Avançada.