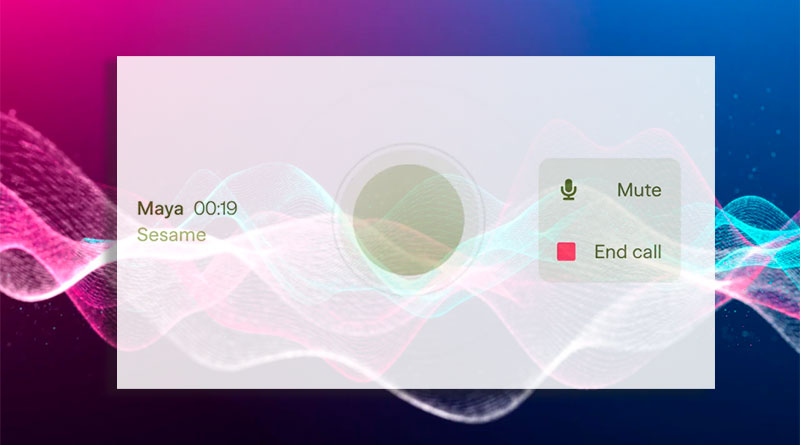

Sesame, l’assistent de veu més natural

Els assistents de veu han evolucionat significativament, però encara els manca un aspecte essencial: la presència de veu. La veu no és només so; transmet emocions, matisos i significat. Els desenvolupadors de Sesame busquen tancar aquesta bretxa amb el seu Model de parla conversacional (CSM), que pretén fer que la comunicació amb assistents d’IA sigui més natural i efectiva.

La importància de la veu en la interacció humana

Les interaccions humanes depenen de la entonació, les pauses i l’emoció. Un assistent digital que parli de manera monòtona pot tornar-se esgotador i poc útil amb el temps. Sesame busca canviar això integrant un model que no només respongui a les sol·licituds, sinó que també participi en un diàleg genuí.

Claus per aconseguir la «presència de veu»

Perquè un assistent de veu sigui realment útil, ha de comptar amb quatre elements fonamentals:

- Intel·ligència emocional: Capacitat per reconèixer i respondre a emocions.

- Dinàmica conversacional: Adaptació al ritme, pauses i interrupcions naturals.

- Consciència del context: Ajust del to i estil segons la situació.

- Personalitat consistent: Mantenir una presència fiable i apropiada.

El repte de la generació de veu conversacional

La generació de veu en IA no només ha de produir àudio d’alta qualitat, sinó també entendre el context en temps real. Els models tradicionals de text a veu (TTS) converteixen text en àudio, però no poden triar la millor entonació sense informació addicional sobre la conversa.

Aquí és on entra en joc el Model de parla conversacional (CSM). Aquest model multimodal, basat en transformadors, utilitza l’historial de la conversa per produir una veu més natural i adaptada al context.

Com funciona el model CSM?

El model CSM empra tokenitzadors per transformar l’àudio en dades processables. Hi ha dos tipus de tokens:

- Tokens semàntics: Capturen característiques clau de la parla, com el to i la fonètica.

- Tokens acústics: Permeten la reconstrucció detallada de l’àudio, conservant característiques naturals.

Aquest model es diferencia dels anteriors perquè processa text i àudio simultàniament. Utilitza dos transformadors autoregressius que generen una veu més coherent i expressiva.

Avaluació i proves del model

El rendiment de CSM es va avaluar amb mètriques objectives i subjectives:

- Objectives: Comparació amb models de TTS en aspectes com la taxa d’error de paraules i la similitud amb la veu humana.

- Subjectives: Estudis amb oients humans que van comparar l’àudio generat amb gravacions reals.

Els resultats van mostrar que, sense context, el model aconsegueix un nivell de naturalitat gairebé humà. No obstant això, quan s’incorpora el context, els oients encara prefereixen la veu humana, cosa que indica que encara hi ha marge per millorar la prosòdia i la continuïtat en les converses.

Futur del model de parla conversacional

L’equip de Sesame planeja expandir el seu model per donar suport a més de 20 idiomes, millorar l’escalabilitat i crear un sistema completament dúplex. Això significa que l’assistent podrà parlar i escoltar simultàniament, cosa que aproparia encara més la interacció a una conversa humana real.

A més, Sesame ha anunciat que alliberarà en codi obert parts clau de la seva investigació, permetent a la comunitat millorar i expandir les seves capacitats.

Preguntes i respostes

Què és el model CSM i què el fa diferent?

El Model de parla conversacional (CSM) és un sistema de generació de veu basat en intel·ligència artificial que utilitza transformadors per crear una parla més natural i expressiva. A diferència dels models tradicionals, CSM incorpora context conversacional, adaptant el to i l’entonació a cada situació.

Com millora la veu conversacional l’experiència amb assistents virtuals?

La veu conversacional afegeix intel·ligència emocional, dinàmica natural i coherència contextual, cosa que fa que la interacció amb assistents de veu sigui més fluida i sembli més humana.

Quins avenços s’esperen en la veu generada per IA?

S’espera que els assistents de veu del futur siguin completament dúplex, és a dir, que puguin parlar i escoltar al mateix temps, comprenent millor les pauses i els torns de conversa. També es busca expandir el suport a més idiomes i millorar la prosòdia perquè la veu soni encara més natural.

Quan estarà disponible aquest model per al públic?

Sesame planeja alliberar parts clau del model en codi obert sota una llicència Apache 2.0, la qual cosa permetrà a desenvolupadors i investigadors experimentar amb la tecnologia i millorar-la.

Com afecta aquest avenç als assistents de veu actuals?

La implementació d’un model conversacional com CSM podria millorar assistents de veu com Alexa, Siri i Google Assistant, fent-los més intuïtius, expressius i útils en la vida quotidiana.e voz como Alexa, Siri y Google Assistant, haciéndolos más intuitivos, expresivos y útiles en la vida cotidiana.