Voz realista de GPT-4o en versión alfa

OpenAI ha comenzado a implementar el Modo de Voz Avanzada de ChatGPT, ofreciendo a los usuarios acceso a las respuestas de audio hiperrealistas de GPT-4o. La versión alfa estará disponible hoy para un pequeño grupo de suscriptores de ChatGPT Plus, y OpenAI afirma que la función se desplegará gradualmente a todos los usuarios Plus en el otoño de 2024.

Detalles de la voz hiperrealista en versión alfa solo para algunos usuarios.

Impacto Inicial y Controversias

Cuando OpenAI presentó por primera vez la voz de GPT-4o en mayo, la función sorprendió al público con respuestas rápidas y una asombrosa semejanza a la voz humana. Una voz en particular, llamada Sky, se parecía a la de Scarlett Johansson, la actriz detrás del asistente artificial en la película «Her». Tras la demostración, Johansson declaró que había rechazado múltiples solicitudes del CEO de OpenAI, Sam Altman, para usar su voz, y, después de ver la demo, contrató asesoría legal para defender su imagen. Aunque OpenAI negó haber utilizado la voz de Johansson, posteriormente eliminó la voz mostrada en la demostración. En junio, OpenAI anunció que retrasaría el lanzamiento del Modo de Voz Avanzada para mejorar sus medidas de seguridad.

Características del Modo de Voz Avanzada

El Modo de Voz Avanzada difiere significativamente del modo de voz previamente disponible en ChatGPT. Anteriormente, ChatGPT usaba tres modelos separados para convertir la voz a texto, procesar el mensaje con GPT-4 y luego convertir el texto de ChatGPT en voz. Sin embargo, GPT-4o es multimodal, capaz de realizar estas tareas sin la ayuda de modelos auxiliares, lo que crea conversaciones con una latencia significativamente menor. OpenAI también afirma que GPT-4o puede detectar intonaciones emocionales en la voz del usuario, incluyendo tristeza, emoción o incluso canto.

Experiencia de Usuario y Seguridad

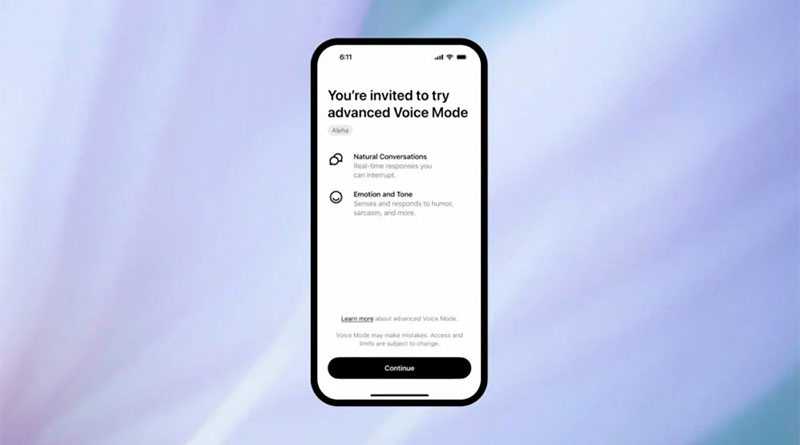

En esta fase piloto, los usuarios de ChatGPT Plus podrán experimentar de primera mano lo hiperrealista que es el Modo de Voz Avanzada de OpenAI. OpenAI dice que está lanzando gradualmente la nueva voz de ChatGPT para monitorizar de cerca su uso. Las personas en el grupo alfa recibirán una alerta en la aplicación de ChatGPT, seguida de un correo electrónico con instrucciones sobre cómo usar la nueva función.

Control de Voz y Evitación de Controversias

El Modo de Voz Avanzada estará limitado a las cuatro voces preestablecidas de ChatGPT: Juniper, Breeze, Cove y Ember, creadas en colaboración con actores de voz pagados. La voz Sky mostrada en la demostración de mayo ya no está disponible en ChatGPT. Lindsay McCallum, portavoz de OpenAI, declaró que «ChatGPT no puede imitar las voces de otras personas, tanto individuos como figuras públicas, y bloqueará las salidas que difieran de una de estas voces preestablecidas».

Futuro del Modo de Voz Avanzada

OpenAI planea expandir el acceso a más usuarios de ChatGPT Plus en las próximas semanas, con un lanzamiento completo para todos los suscriptores Plus previsto para este otoño. Esta expansión permitirá que más usuarios experimenten y proporcionen retroalimentación sobre esta innovadora función, ayudando a OpenAI a mejorar y perfeccionar el Modo de Voz Avanzada.