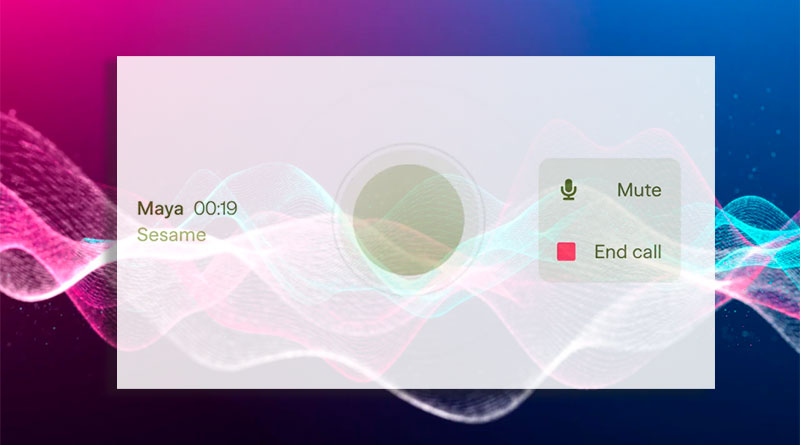

Sesame, el asistente de voz más natural

Los asistentes de voz han evolucionado significativamente, pero aún carecen de un aspecto esencial: la presencia de voz. La voz no es solo sonido; transmite emociones, matices y significado. Los desarrolladores de Sesame buscan cerrar esta brecha con su Modelo de habla conversacional (CSM), que pretende hacer que la comunicación con asistentes de IA sea más natural y efectiva.

La importancia de la voz en la interacción humana

Las interacciones humanas dependen de la entonación, las pausas y la emoción. Un asistente digital que hable de manera monótona puede volverse agotador y poco útil con el tiempo. Sesame busca cambiar esto al integrar un modelo que no solo responda solicitudes, sino que también participe en un diálogo genuino.

Claves para lograr la «presencia de voz»

Para que un asistente de voz sea realmente útil, debe contar con cuatro elementos fundamentales:

- Inteligencia emocional: Capacidad para reconocer y responder a emociones.

- Dinámica conversacional: Adaptación al ritmo, pausas e interrupciones naturales.

- Conciencia del contexto: Ajuste del tono y estilo según la situación.

- Personalidad consistente: Mantener una presencia fiable y apropiada.

El desafío de la generación de voz conversacional

La generación de voz en IA no solo debe producir audio de alta calidad, sino también entender el contexto en tiempo real. Los modelos tradicionales de texto a voz (TTS) convierten texto en audio, pero no pueden elegir la mejor entonación sin información adicional sobre la conversación.

Aquí es donde entra en juego el Modelo de habla conversacional (CSM). Este modelo multimodal, basado en transformadores, usa el historial de la conversación para producir una voz más natural y adaptada al contexto.

¿Cómo funciona el modelo CSM?

El modelo CSM emplea tokenizadores para transformar el audio en datos procesables. Existen dos tipos de tokens:

- Tokens semánticos: Capturan características clave del habla, como el tono y la fonética.

- Tokens acústicos: Permiten la reconstrucción detallada del audio, conservando características naturales.

Este modelo se diferencia de los anteriores porque procesa texto y audio simultáneamente. Utiliza dos transformadores autorregresivos que generan una voz más coherente y expresiva.

Evaluación y pruebas del modelo

El rendimiento de CSM se evaluó con métricas objetivas y subjetivas:

- Objetivas: Comparación con modelos de TTS en aspectos como tasa de error de palabras y similitud con la voz humana.

- Subjetivas: Estudios con oyentes humanos que compararon el audio generado con grabaciones reales.

Los resultados mostraron que, sin contexto, el modelo logra un nivel de naturalidad casi humano. Sin embargo, cuando se incorpora el contexto, los oyentes todavía prefieren la voz humana, lo que indica que aún hay espacio para mejorar la prosodia y la continuidad en las conversaciones.

Futuro del modelo de habla conversacional

El equipo de Sesame planea expandir su modelo para soportar más de 20 idiomas, mejorar la escalabilidad y crear un sistema completamente dúplex. Esto significa que el asistente podrá hablar y escuchar simultáneamente, lo que acercaría aún más la interacción a una conversación humana real.

Además, Sesame ha anunciado que liberará en código abierto partes clave de su investigación, permitiendo a la comunidad mejorar y expandir sus capacidades.

Preguntas y respuestas

¿Qué es el modelo CSM y qué lo hace diferente?

El Modelo de habla conversacional (CSM) es un sistema de generación de voz basado en inteligencia artificial que utiliza transformadores para crear un habla más natural y expresiva. A diferencia de los modelos tradicionales, CSM incorpora contexto conversacional, adaptando el tono y la entonación a cada situación.

¿Cómo mejora la voz conversacional la experiencia con asistentes virtuales?

La voz conversacional añade inteligencia emocional, dinámica natural y coherencia contextual, lo que hace que la interacción con asistentes de voz sea más fluida y parezca más humana.

¿Qué avances se esperan en la voz generada por IA?

Se espera que los asistentes de voz del futuro sean completamente dúplex, es decir, que puedan hablar y escuchar al mismo tiempo, comprendiendo mejor las pausas y los turnos de conversación. También se busca expandir el soporte a más idiomas y mejorar la prosodia para que la voz suene aún más natural.

¿Cuándo estará disponible este modelo para el público?

Sesame planea liberar partes clave del modelo en código abierto bajo una licencia Apache 2.0, lo que permitirá a desarrolladores e investigadores experimentar con la tecnología y mejorarla.

¿Cómo afecta este avance a los asistentes de voz actuales?

La implementación de un modelo conversacional como CSM podría mejorar asistentes de voz como Alexa, Siri y Google Assistant, haciéndolos más intuitivos, expresivos y útiles en la vida cotidiana.