Ollama lanza app para Windows y MacOS

Ollama, una herramienta fundamental para el uso de modelos de lenguaje grandes (LLM) de forma local, ha dado un paso gigante al lanzar una nueva aplicación con interfaz gráfica para los sistemas operativos Windows y macOS. Esta actualización simplifica drásticamente la interacción con la inteligencia artificial, eliminando la necesidad de usar la terminal. Con esta nueva versión, la compañía busca acercar la potencia de la IA a un público mucho más amplio, incluyendo a usuarios que no tienen conocimientos avanzados de programación o de línea de comandos. Esta democratización del acceso a la inteligencia artificial marca un hito importante, permitiendo a más personas experimentar y aprovechar las capacidades de los LLMs directamente desde sus ordenadores personales de una manera más intuitiva y amigable.

Una interfaz de usuario que facilita la interacción

La principal innovación de esta nueva versión es, sin duda, su interfaz gráfica de usuario (GUI). Antes, el uso de Ollama estaba limitado a quienes se sentían cómodos con la línea de comandos, lo que creaba una barrera de entrada para muchos. Ahora, la aplicación ofrece una experiencia de uso muy similar a la de cualquier chatbot de IA conocido, lo que permite a los usuarios interactuar con los modelos de una manera conversacional y directa. Este cambio es crucial para que la IA local sea una opción viable y atractiva para el usuario común. La instalación también se ha simplificado, ya que la GUI y los componentes de la línea de comandos se instalan juntos, y la aplicación puede ser accedida fácilmente desde el menú de inicio o la bandeja del sistema.

Funcionalidades avanzadas al alcance de todos

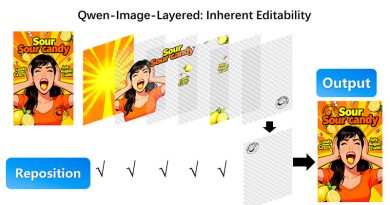

Más allá de la simplificación de la interacción, la nueva aplicación de Ollama integra funcionalidades muy poderosas que mejoran su utilidad. Una de las características más destacadas es la compatibilidad con la función de arrastrar y soltar archivos. Los usuarios pueden simplemente arrastrar un documento de texto, un PDF, una imagen o incluso un archivo de código a la aplicación para que el LLM lo procese. Por ejemplo, es posible pedirle a la IA que analice un documento extenso o que explique el código de un archivo de programación. Este soporte multimodal permite el procesamiento de diferentes tipos de datos, lo que amplía enormemente las posibilidades de uso de los modelos locales. Además, la aplicación ahora es capaz de interpretar imágenes, lo que permite a los usuarios interactuar con modelos que tengan soporte multimodal, como el reciente modelo Gemma 3.

Requisitos de hardware para un rendimiento óptimo

A pesar de que el software ha mejorado en usabilidad, el hardware del ordenador sigue siendo un factor clave para el rendimiento de los LLMs. Para obtener una buena experiencia, se recomiendan al menos 16 GB de RAM y un procesador potente, como un Intel de 11ª generación o un AMD basado en Zen 4. Aunque no es indispensable, contar con una tarjeta gráfica dedicada (GPU) mejorará significativamente el rendimiento, especialmente al trabajar con modelos de mayor tamaño. Es importante tener en cuenta que, por el momento, la aplicación no utiliza las Unidades de Procesamiento Neuronal (NPU) de los nuevos ordenadores, por lo que el rendimiento dependerá del resto del sistema. El uso de un LLM local ofrece la gran ventaja de la privacidad, ya que los datos se procesan en el propio ordenador del usuario, sin necesidad de enviarlos a la nube.

La línea de comandos sigue siendo útil

A pesar de todas las mejoras de la interfaz gráfica, la línea de comandos (CLI) no ha perdido su valor. Algunas operaciones más avanzadas, como publicar, crear, copiar o eliminar modelos, todavía se realizan a través de la terminal. Por lo tanto, aunque la nueva aplicación es excelente para el uso cotidiano, se recomienda que los usuarios que deseen explorar las capacidades más profundas de Ollama se familiaricen con la CLI. Este conocimiento sigue siendo una habilidad valiosa que complementa el uso de la interfaz gráfica, permitiendo una gestión más completa y avanzada de los modelos de lenguaje.

Preguntas y Respuestas

¿Qué es lo más destacado de la nueva aplicación de Ollama para Windows y macOS?

Lo más destacado es su nueva interfaz gráfica de usuario (GUI), que elimina la necesidad de usar la línea de comandos para interactuar con los modelos de lenguaje. Esto hace que la IA local sea mucho más accesible para usuarios sin conocimientos técnicos.

¿Qué tipo de archivos puedo procesar con la nueva aplicación?

La aplicación permite procesar diversos tipos de archivos, incluyendo documentos de texto, PDFs, imágenes, documentos de Word y archivos de código, gracias a su función de arrastrar y soltar.

¿Cuáles son los requisitos de hardware recomendados para usar Ollama de forma eficiente?

Se recomienda un mínimo de 16 GB de RAM unificada y un procesador potente. Aunque no es obligatoria, una tarjeta gráfica dedicada (GPU) mejora significativamente el rendimiento, especialmente para modelos más grandes.

¿Sigue siendo útil la línea de comandos después de este lanzamiento?

Sí, la línea de comandos (CLI) sigue siendo necesaria para realizar operaciones avanzadas como publicar, crear o eliminar modelos, por lo que su conocimiento es un complemento valioso para el uso de la aplicación con GUI.