Kimi k2 thinking: el nuevo agente de ia

El reciente lanzamiento del modelo de inteligencia artificial Kimi K2 Thinking por parte de Moonshot AI, una de las firmas tecnológicas más prominentes de China, marca un antes y un después en el sector global de la IA. Este modelo, descrito como un «agente de pensamiento», está diseñado para el razonamiento complejo y la ejecución de tareas de manera completamente autónoma. Con su llegada, se ha reducido significativamente la brecha de rendimiento que existía entre los modelos de acceso libre (código abierto) y los modelos de propiedad privada más avanzados, demostrando el rápido progreso de la tecnología china.

La llegada de kimi k2 thinking: un salto en la inteligencia agéntica

Presentado el 6 de noviembre de 2025, Kimi K2 Thinking no es solo un modelo de lenguaje grande (LLM) más. Moonshot AI lo ha concebido específicamente para ir más allá de la mera generación de texto. El enfoque principal está en el razonamiento profundo, la orquestación de herramientas sin supervisión y las capacidades avanzadas de codificación. Este movimiento es parte de la estrategia de la compañía para destacarse en el saturado mercado chino, conocido por la «guerra de los cien modelos», cambiando el foco de la velocidad y el precio hacia una sofisticada inteligencia agéntica. Este modelo está disponible para la comunidad a través de plataformas como Hugging Face y mediante una API compatible con el estándar de OpenAI.

Innovaciones clave: arquitectura y eficiencia

La potencia de este agente reside en una arquitectura Mixture-of-Experts (MoE), lo que permite al modelo gestionar un total de 1 billón de parámetros, aunque solo 32 mil millones están activos en cada inferencia. Esta estructura lo hace muy eficiente a pesar de su inmenso tamaño. Además de su arquitectura, una característica técnica destacada es su ventana de contexto de 256.000 tokens, una capacidad que le permite procesar grandes cantidades de información, como códigos de software completos o extensos documentos, facilitando la ejecución de tareas complejas.

Optimización de rendimiento con cuantización nativa INT4

Una de las mayores innovaciones de Kimi K2 Thinking es la implementación de la cuantización nativa INT4. Lograda mediante un proceso llamado Entrenamiento Consciente de la Cuantización (QAT), esta técnica duplica la velocidad de inferencia (generación de respuestas) y reduce significativamente el consumo de memoria de la GPU sin sacrificar el rendimiento. De hecho, los resultados de sus evaluaciones se publicaron utilizando esta precisión INT4, demostrando su eficacia en escenarios de uso real.

Un agente de pensamiento que redefine los estándares

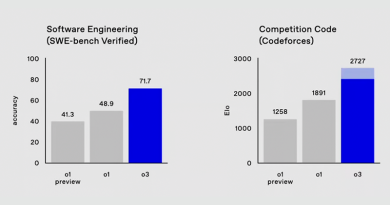

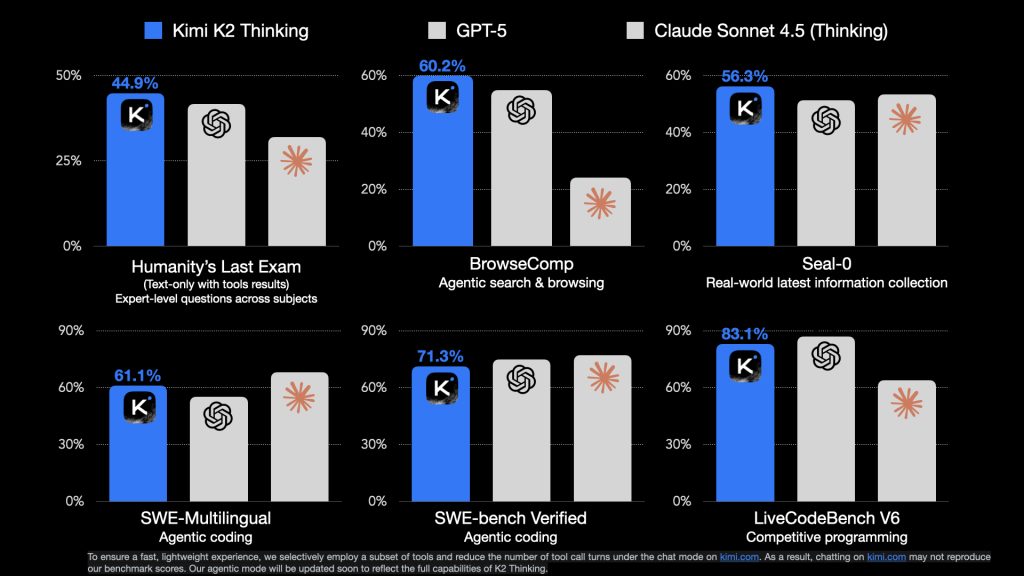

La capacidad central de este modelo como «agente pensante» le permite intercalar procesos de razonamiento de cadena de pensamiento con múltiples llamadas a funciones o herramientas. Su rendimiento es notable: puede sostener un comportamiento coherente y orientado a objetivos a lo largo de 200 a 300 invocaciones secuenciales de herramientas. Modelos anteriores solían fallar o degradarse después de solo 30 a 50 pasos. Esta habilidad ha permitido que Kimi K2 Thinking establezca nuevos récords en evaluaciones clave. Por ejemplo, superó a modelos propietarios líderes en el benchmark Humanity’s Last Exam (HLE) y en tareas de navegación web agéntica como BrowseComp, mostrando su destreza en razonamiento experto y búsqueda avanzada.

El impacto en el mercado global de inteligencia artificial

El lanzamiento no solo es un logro técnico, sino también un indicador claro de la tendencia en la industria de la IA. Por un lado, subraya el rápido ascenso de los laboratorios chinos como DeepSeek, Qwen y Moonshot AI, que están ganando una cuota de atención creciente en la comunidad global de la IA. Por otro lado, esto ejerce una presión considerable sobre los laboratorios occidentales con modelos cerrados como OpenAI y Anthropic. La existencia de alternativas de código abierto tan potentes y eficientes obliga a los gigantes a justificar sus altos precios y a diferenciarse con características que vayan más allá de los resultados en los tests estándar.

La respuesta de la comunidad de desarrolladores y usuarios ha sido muy positiva. Los usuarios han destacado la excepcional capacidad del modelo en escritura creativa y codificación práctica. Un usuario llegó a afirmar que «Kimi 2 es la IA de escritura creativa #1 en este momento», mientras que otros elogiaron su capacidad para generar código funcional, incluso para un juego completo como Space Invaders, a partir de una sola instrucción. Este entusiasmo confirma que el mercado está evolucionando hacia sistemas de IA que pueden planificar y ejecutar tareas complejas de forma autónoma, marcando el camino de la inteligencia agéntica.

Preguntas frecuentes

¿Qué significa que kimi k2 thinking sea un «agente de pensamiento»?

Significa que el modelo no solo genera texto, sino que está diseñado para realizar un razonamiento profundo (a menudo llamado «cadena de pensamiento») y puede planificar y ejecutar de manera autónoma una larga secuencia de acciones o llamadas a herramientas (como buscar en internet o ejecutar código) para resolver un problema complejo, imitando el proceso de pensamiento humano.

¿Cómo es de «código abierto» el modelo kimi k2 thinking?

Se publica bajo una Licencia MIT Modificada. Es muy permisiva y permite el uso comercial de manera amplia. Sin embargo, incluye una cláusula específica que requiere que los productos o servicios muy grandes (con más de 100 millones de usuarios o 20 millones de dólares en ingresos mensuales) muestren la atribución «Kimi K2» en su interfaz de usuario. Por ello, algunos lo consideran un modelo de «pesos abiertos» (open weight) más que de código abierto puro según la definición tradicional.

¿Qué ventajas ofrece la cuantización nativa INT4?

La cuantización nativa INT4 es una innovación técnica que duplica la velocidad de generación de respuestas del modelo y al mismo tiempo reduce el uso de la memoria de la GPU necesaria para ejecutarlo. Esto hace que el despliegue del modelo sea mucho más eficiente en términos de costes y energía, permitiendo que más desarrolladores lo utilicen en producción.