Cerebras lanza la inferencia de IA más rápida del mundo

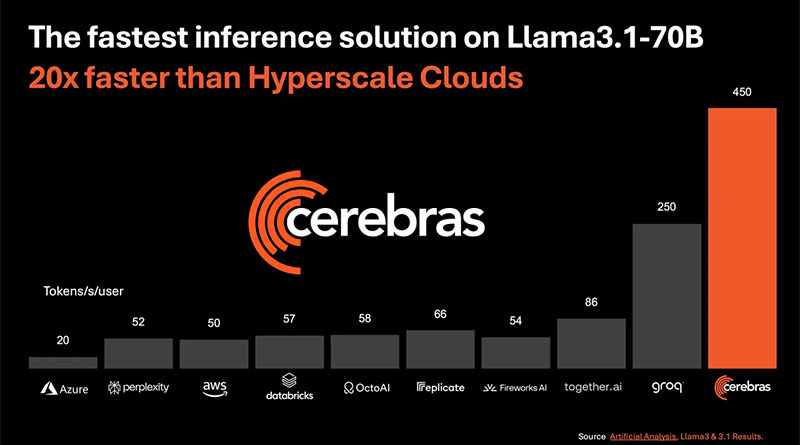

Cerebras Systems, una empresa pionera en el ámbito de la computación de alto rendimiento para inteligencia artificial (IA), ha lanzado su solución más reciente: Cerebras Inference, un sistema que promete ser el más rápido del mundo en la ejecución de inferencias de IA. Este nuevo sistema ofrece una velocidad asombrosa, procesando hasta 1,800 tokens por segundo para el modelo Llama3.1 8B y 450 tokens por segundo para el modelo Llama3.1 70B, lo que lo posiciona 20 veces más rápido que las soluciones basadas en GPU de NVIDIA en nubes a gran escala.

Velocidad sin precedentes y precisión mantenida

Una de las características más destacadas de Cerebras Inference es su capacidad para mantener una alta precisión en las inferencias, logrando resultados dentro del dominio de 16 bits a lo largo de toda la ejecución, sin comprometer la precisión en favor del rendimiento. Esto es particularmente relevante ya que, en comparación con otras soluciones, la oferta de Cerebras no solo es más rápida sino que también garantiza una exactitud en el procesamiento que respeta los estándares más altos de calidad.

Un rendimiento 20 veces superior

Según declaraciones de Micah Hill-Smith, cofundador y CEO de Artificial Analysis, Cerebras Inference ha superado significativamente las soluciones basadas en GPU en los benchmarks de inferencia de IA para los modelos Llama 3.1 de Meta. Las mediciones realizadas demuestran que el sistema de Cerebras alcanza más de 1,800 tokens por segundo en Llama 3.1 8B y más de 446 tokens por segundo en Llama 3.1 70B, estableciendo un nuevo récord en estos indicadores de rendimiento.

Un cambio de paradigma en la inferencia de IA

El sector de la inferencia de IA es el de mayor crecimiento dentro del mercado de hardware para inteligencia artificial, representando aproximadamente el 40% del total. La capacidad de procesar más de 1,000 tokens por segundo marca un hito comparable a la introducción del internet de banda ancha, liberando nuevas oportunidades y anunciando una nueva era para las aplicaciones de IA. Con una velocidad 20 veces mayor que las soluciones tradicionales, Cerebras Inference permite a los desarrolladores construir aplicaciones de IA de próxima generación, que requieren un rendimiento en tiempo real complejo y de múltiples etapas, como los agentes de IA.

Precios competitivos y opciones de acceso

Cerebras ha estructurado su servicio de inferencia en tres niveles con precios altamente competitivos:

- Free Tier: Proporciona acceso gratuito a la API con límites de uso generosos, disponible para cualquier usuario registrado.

- Developer Tier: Diseñado para despliegues flexibles y sin servidor, este nivel ofrece un punto final API a una fracción del costo de las alternativas del mercado. Los modelos Llama 3.1 8B y 70B están disponibles a 10 y 60 centavos por millón de tokens, respectivamente.

- Enterprise Tier: Ofrece modelos afinados, acuerdos de nivel de servicio personalizados y soporte dedicado, ideal para cargas de trabajo continuas. Las empresas pueden acceder al servicio de inferencia de Cerebras a través de una nube privada gestionada o en las instalaciones del cliente, con precios disponibles a solicitud.

Asociaciones estratégicas para el desarrollo de la IA

El desarrollo de aplicaciones de IA requiere un conjunto diverso de herramientas especializadas en cada etapa, desde modelos de código abierto hasta frameworks que permiten un desarrollo rápido, como LangChain y LlamaIndex. Cerebras está colaborando con líderes de la industria como Docker, Nasdaq, Weights & Biases, Weaviate, AgentOps y Log10, para impulsar el futuro de la IA.

Estas asociaciones estratégicas refuerzan la posición de Cerebras Inference como una solución integral para los desarrolladores que buscan potenciar aplicaciones de IA con capacidades avanzadas y tiempos de respuesta ultra rápidos.

Soporte técnico de vanguardia

El sistema Cerebras CS-3 impulsa esta solución de inferencia, utilizando el procesador de IA más avanzado del mundo, el Wafer Scale Engine 3 (WSE-3). A diferencia de las unidades de procesamiento gráfico (GPU), que obligan a los usuarios a comprometerse entre velocidad y capacidad, el CS-3 ofrece el mejor rendimiento por usuario al tiempo que garantiza un alto rendimiento general. Con una ancho de banda de memoria 7,000 veces mayor que el Nvidia H100, el WSE-3 resuelve el desafío técnico fundamental de la IA generativa: el ancho de banda de memoria.

Acceso y compatibilidad

Los desarrolladores pueden acceder fácilmente a la API de inferencia de Cerebras, que es totalmente compatible con la API de OpenAI Chat Completions, lo que permite una migración sin problemas con solo unas pocas líneas de código.

El impacto de la velocidad en la adopción de la IA

Numerosos líderes en IA han expresado su entusiasmo por las capacidades de Cerebras Inference. Por ejemplo, Kim Branson, vicepresidente senior de IA/ML en GlaxoSmithKline, destacó que «la velocidad y la escala lo cambian todo«, subrayando cómo las mejoras en la velocidad pueden revolucionar las aplicaciones de IA.

Russell D’sa, CEO y cofundador de LiveKit, mencionó cómo la combinación de las capacidades de cómputo de Cerebras y los modelos de última generación con la red global de LiveKit permite crear experiencias de IA multimodales con latencia ultra baja y características más humanas.

En el ámbito de los motores de búsqueda, Denis Yarats, CTO y cofundador de Perplexity, señaló que las velocidades de inferencia ultra rápidas como las que demuestra Cerebras pueden cambiar la forma en que los usuarios interactúan con las futuras plataformas de búsqueda inteligente.

Finalmente, Anil Varanasi, CEO de Meter, comentó sobre la importancia de la velocidad en la infraestructura, afirmando que el rendimiento de Cerebras Inference mejora la capacidad de Meter Command para generar software personalizado y tomar acciones con la misma facilidad y rapidez con la que se realizan búsquedas en la web.

Cerebras Inference se posiciona como una solución revolucionaria en el campo de la inferencia de IA, ofreciendo una combinación única de velocidad, precisión y escalabilidad. Con su capacidad para superar significativamente las ofertas basadas en GPU y su enfoque en mantener la precisión sin compromisos, Cerebras Systems está empujando los límites de lo posible en el desarrollo de aplicaciones de IA. Sus asociaciones estratégicas y su modelo de precios competitivo refuerzan su posición como líder en este campo en rápida evolución.

Con esta nueva tecnología, Cerebras no solo está ofreciendo una mejora incremental, sino que está transformando fundamentalmente cómo se realiza la inferencia de IA, abriendo la puerta a nuevas posibilidades para desarrolladores y empresas en todo el mundo.