LM Studio: integración MCP

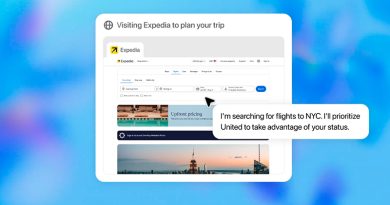

La reciente actualización 0.3.17 de LM Studio ha marcado un antes y un después en el manejo de los Modelos de Lenguaje Grandes (LLM) en entornos locales. La principal novedad es la integración del Protocolo de Contexto del Modelo (MCP), una innovación que permite a los LLM instalados en tu propio equipo interactuar con una gran variedad de herramientas y recursos externos. Hasta ahora, estos modelos operaban de forma «aislada», capaces de razonar pero sin la posibilidad de llevar a cabo acciones prácticas en el mundo digital. Con la llegada del MCP, esta limitación desaparece, transformando los LLM en auténticos agentes interactivos y eficientes.

El MCP, desarrollado inicialmente por Anthropic y ahora de código abierto, funciona como una especie de «API para APIs» que estandariza cómo la inteligencia artificial consume servicios. Esta funcionalidad no solo incrementa drásticamente la utilidad de los LLM locales, sino que también refuerza aspectos cruciales como la privacidad y el control del usuario. Al permitir que las operaciones se realicen sin depender de servicios en la nube, se asegura que tus datos y acciones permanezcan en tu entorno.

Entendiendo el Protocolo de Contexto del Modelo (MCP)

El Protocolo de Contexto del Modelo es un estándar abierto diseñado para facilitar la comunicación fluida entre los LLM y las herramientas externas. Se compone de dos elementos fundamentales:

Anfitrión MCP y Servidor MCP: La clave de la interacción

- Anfitrión MCP: Esta es la aplicación donde reside el LLM. Su función principal es descubrir las herramientas disponibles, presentarlas al modelo durante el proceso de inferencia y gestionar todo el ciclo de vida de las llamadas a estas herramientas. En este contexto, LM Studio es el anfitrión MCP.

- Servidor MCP: Se trata de un programa que pone a disposición un conjunto de herramientas, o funciones, a través de un punto final HTTP. Estos servidores pueden ser desde un sencillo script ejecutándose en tu máquina local hasta robustos servicios empresariales accesibles a través de internet. La verdadera fortaleza del protocolo reside en su sencillez y estandarización, lo que permite que cualquier desarrollador pueda crear un servidor que exponga herramientas y que cualquier aplicación anfitriona pueda conectarse a él, fomentando así un ecosistema verdaderamente agnóstico de proveedor.

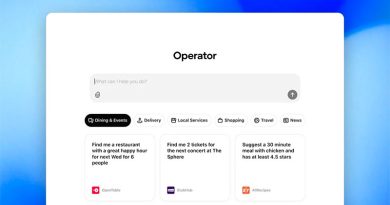

La incorporación del MCP convierte a los LLM en «agentes de IA» con la capacidad de ejecutar acciones concretas. Por ejemplo, un LLM podría interactuar con tus dispositivos inteligentes en casa, gestionar sistemas de pago como Stripe, o incluso navegar por plataformas como Hugging Face para buscar modelos y conjuntos de datos. La comunidad Activepieces, por ejemplo, ya ha desarrollado más de 280 herramientas MCP de código abierto, lo que posibilita a los LLM realizar tareas complejas como «Cancelar todas mis reuniones de mañana» o «Escribir un tuit y publicarlo», demostrando el potencial ilimitado de esta integración.

El Futuro de los LLM Locales y Conectados

La integración del MCP en LM Studio no es simplemente una actualización menor; representa un «cambio fundamental» que «cierra la brecha entre la inteligencia pura de los LLM y la utilidad práctica de las aplicaciones de software.» Esto allana el camino hacia un futuro en el que la IA no es solo un conversador, sino «un asistente personalizado que opera de forma segura en su propio hardware.»

Algunos ejemplos de este futuro incluyen:

- Un escritor que utiliza un servidor MCP local con herramientas personalizadas para resumir, verificar hechos con su propia biblioteca de documentos y analizar el estilo, todo ello sin enviar información a la nube.

- Un desarrollador cuyo LLM puede interactuar con un servidor local para ejecutar pruebas, leer la salida del compilador y buscar dentro de sus bases de código internas.

Al adoptar un estándar abierto y priorizar el control del usuario, LM Studio ha establecido un marco potente para la próxima generación de IA personal, autónoma y segura.

Preguntas Frecuentes sobre LM Studio y MCP

¿Qué significa que un LLM local se convierta en un «agente de IA» con MCP?

Con la integración de MCP, un LLM local puede ir más allá de simplemente generar texto o responder preguntas; ahora puede ejecutar acciones prácticas. Por ejemplo, puede interactuar con otras aplicaciones, gestionar archivos en tu sistema o incluso conectarse a servicios web, actuando como un asistente inteligente y proactivo en tu propio hardware.

¿Cuáles son las ventajas de usar servidores MCP locales en lugar de remotos?

La principal ventaja de los servidores MCP locales es la mejora significativa en la privacidad y el control de tus datos. Al ejecutar las operaciones directamente en tu máquina, la información sensible nunca sale de tu entorno local, lo que reduce los riesgos de seguridad y dependencia de servicios en la nube.

¿Cómo puedo asegurarme de la seguridad al usar servidores MCP en LM Studio?

LM Studio implementa un sistema de confirmación para las llamadas a herramientas. Antes de que un LLM ejecute una acción a través de un servidor MCP, se te presentará un diálogo detallado para que revises y apruebes la operación. Es crucial que siempre examines estas solicitudes y nunca concedas permisos a servidores MCP de fuentes desconocidas o no confiables. Puedes gestionar los permisos en la configuración de la aplicación.

¿Necesito un modelo específico para aprovechar las capacidades de MCP en LM Studio?

Sí, para utilizar plenamente las capacidades de MCP, necesitarás un modelo LLM que soporte la «llamada a funciones» (function calling). Modelos como las variantes de Llama 3, Mixtral o Qwen son ejemplos de aquellos que están diseñados para interactuar con herramientas externas.

¿Qué debo hacer si un servidor MCP consume demasiados tokens o ralentiza mi modelo local?

Algunos servidores MCP, especialmente aquellos originalmente diseñados para modelos en la nube, pueden ser ineficientes en el uso de tokens. Si observas que tu modelo local se ralentiza o experimenta desbordamientos de contexto frecuentes, verifica la configuración del servidor y considera si es apropiado para un entorno local. En algunos casos, podría ser necesario buscar alternativas o ajustar la forma en que el servidor interactúa con el modelo.