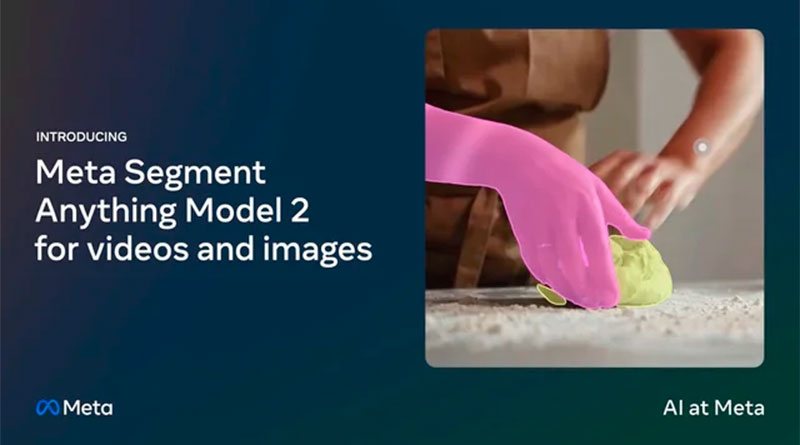

Meta Segment Anything Model 2 – SAM 2

Meta ha lanzado SAM 2, la nueva generación de su modelo de segmentación de objetos, capaz de trabajar con imágenes y videos en tiempo real. Este modelo unificado permite la segmentación precisa y rápida sin necesidad de adaptaciones personalizadas, abriendo una variedad de aplicaciones prácticas en ciencia, medicina, creación de contenidos y más. SAM 2 se destaca por su capacidad de generalización de cero-shot, mejorando significativamente el rendimiento en comparación con modelos anteriores y reduciendo el tiempo de interacción humana en tres veces.

El modelo se presenta con el conjunto de datos SA-V, que incluye aproximadamente 51,000 videos y más de 600,000 «masklets» (máscaras espaciotemporales). Este conjunto de datos es 4.5 veces más grande y tiene 53 veces más anotaciones que los conjuntos de datos existentes. La apertura del código y los pesos del modelo bajo la licencia Apache 2.0 fomenta la investigación y el desarrollo abierto, permitiendo a la comunidad explorar nuevas capacidades y casos de uso.

Características principales de SAM 2:

1. Segmentación de objetos en imágenes y videos:

- SAM 2 supera las capacidades anteriores en precisión de segmentación de imágenes y rendimiento en videos.

- Se requiere un tercio del tiempo de interacción para lograr resultados comparables a los modelos anteriores.

- Capaz de segmentar cualquier objeto en cualquier video o imagen sin adaptación personalizada.

2. Avances en la arquitectura:

- La arquitectura SAM 2 generaliza de imágenes a videos, usando un mecanismo de memoria para recordar información previa y mejorar la segmentación a lo largo del tiempo.

- La inclusión de un módulo de atención a la memoria permite una segmentación precisa en cada cuadro del video, incluso en escenarios de oclusión o desaparición del objeto.

3. Dataset SA-V:

- Con más de 600,000 anotaciones de masklets en aproximadamente 51,000 videos, cubriendo una amplia diversidad geográfica y situaciones del mundo real.

- Incluye tanto objetos completos como partes de objetos y situaciones desafiantes donde los objetos se ocluyen, desaparecen y reaparecen.

4. Aplicaciones potenciales:

- Creación de efectos de video, edición de video, y aplicaciones científicas como el seguimiento de células en videos microscópicos.

- Herramientas de anotación más rápidas para datos visuales, mejorando sistemas de visión por computadora en vehículos autónomos y otras tecnologías.

- Nuevas formas de seleccionar e interactuar con objetos en tiempo real o en videos en vivo.

5. Interactividad y precisión:

- La capacidad de SAM 2 para manejar la ambigüedad al generar múltiples máscaras en cada paso del video y permitir la refinación iterativa a través de interacciones adicionales.

- Mejoras en el seguimiento de objetos a pesar de cambios drásticos en el punto de vista de la cámara, oclusiones prolongadas, y escenas concurridas.

SAM 2 representa un salto cualitativo en la tecnología de segmentación de objetos, unificando el procesamiento de imágenes y videos con una precisión y velocidad sin precedentes. La colaboración abierta y la disponibilidad de recursos permiten a la comunidad de IA explorar nuevas fronteras en la segmentación visual, abriendo un abanico de posibilidades para innovaciones futuras.