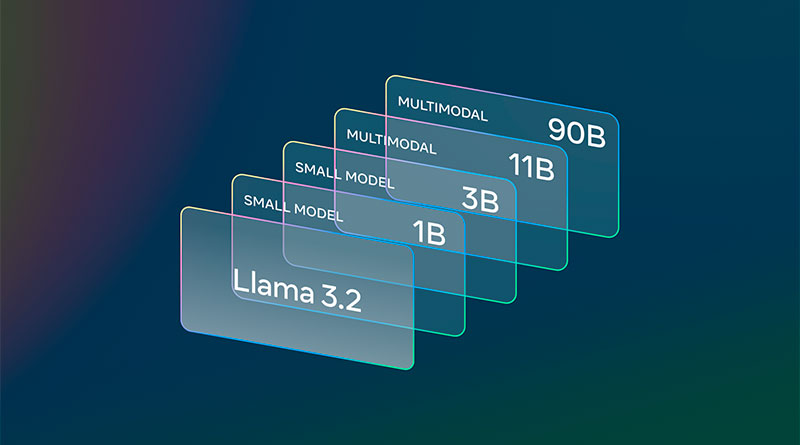

Llama 3.2: Revolucionando la IA y la Visión de Vanguardia con Modelos Abiertos y Personalizables

La Inteligencia Artificial (IA) avanza rápidamente, y con cada nueva versión, las barreras tecnológicas se derrumban, permitiendo más innovación y accesibilidad. Meta ha sido una de las principales impulsoras de esta revolución, y con el lanzamiento de Llama 3.2, estamos ante un hito que cambia las reglas del juego. Este artículo profundiza en los detalles de Llama 3.2, sus capacidades, su ecosistema, y cómo está transformando la IA con modelos más abiertos, personalizables y eficientes.

Introducción a Llama 3.2

Llama 3.2 es la nueva versión de los modelos de lenguaje de gran tamaño (LLM) que Meta ha desarrollado para ofrecer una mayor flexibilidad y rendimiento tanto en procesamiento de lenguaje como en comprensión visual. Esta versión incluye modelos más ligeros, diseñados para funcionar en dispositivos móviles y de gama alta, así como modelos de visión capaces de realizar tareas avanzadas de comprensión de imágenes. Además, Meta ha facilitado su descarga y desarrollo inmediato en un amplio ecosistema de plataformas tecnológicas, reafirmando su compromiso con la apertura y la colaboración.

¿Qué Hace que Llama 3.2 Sea Diferente?

Los modelos de Llama 3.2, especialmente los más ligeros como el 1B y el 3B, están diseñados para operar en dispositivos móviles, manteniendo la privacidad al procesar datos de forma local. Esto significa que las aplicaciones que utilizan estos modelos pueden funcionar sin depender de la nube, lo que mejora tanto la velocidad de procesamiento como la seguridad de los datos personales.

En cuanto a los modelos más grandes, como el 11B y el 90B, la novedad radica en su capacidad para comprender imágenes y realizar tareas de razonamiento visual. Esta habilidad convierte a Llama 3.2 en una herramienta multimodal versátil que puede manejar tanto texto como imágenes, abriendo la puerta a aplicaciones más sofisticadas, desde subtitulado automático hasta análisis de datos visuales complejos.

Llama 3.2: Potencial y Alcance

Modelos Ligeros para el Procesamiento Local

Uno de los aspectos más destacados de Llama 3.2 es la introducción de modelos ligeros como el 1B y el 3B. Estos modelos están optimizados para operar en dispositivos con capacidad limitada, como smartphones y tablets, pero sin sacrificar la potencia ni el rendimiento. Gracias a la arquitectura de procesamiento local, estos modelos pueden ejecutar tareas como resúmenes de texto, seguimiento de instrucciones y generación multilingüe sin depender de conexiones externas.

La ventaja de tener el procesamiento directamente en el dispositivo es doble: por un lado, se reduce la latencia, ya que las respuestas son prácticamente instantáneas, y por otro, se garantiza la privacidad de los datos, un aspecto cada vez más importante en el entorno actual. Estos modelos, por tanto, son ideales para aplicaciones donde la seguridad y la rapidez son claves.

Modelos de Visión: Un Nuevo Horizonte para la IA

Llama 3.2 no se detiene en el procesamiento de lenguaje. Sus modelos de visión, como el 11B y el 90B, permiten que la IA no solo interprete texto, sino también imágenes. Esto abre un sinfín de posibilidades en áreas como el análisis visual, la subtitulación automática de imágenes, la interpretación de gráficos y la localización de objetos.

Imagina una herramienta que puede analizar una imagen de un gráfico financiero y, basándose en la información visual, ofrecer una interpretación textual del rendimiento de una empresa a lo largo del tiempo. O piensa en una IA que pueda interpretar un mapa y responder preguntas como «¿cuándo se vuelve más empinada la caminata en esta ruta?». Este tipo de aplicaciones son posibles gracias a la capacidad de razonamiento visual de Llama 3.2.

Ecosistema de Desarrollo de Llama 3.2

Llama Stack: Simplificación para los Desarrolladores

Para facilitar la adopción y el desarrollo sobre Llama 3.2, Meta ha lanzado Llama Stack, un conjunto de herramientas y bibliotecas diseñadas para integrar sin problemas estos modelos en diversas aplicaciones. Con una estrecha integración con bibliotecas PyTorch, Llama Stack ofrece a los desarrolladores la posibilidad de ajustar y personalizar los modelos según sus necesidades específicas. Además, la compatibilidad con plataformas como Qualcomm, MediaTek y procesadores ARM permite que los modelos ligeros se ejecuten en una amplia gama de dispositivos móviles.

Llama Stack no solo simplifica el proceso de desarrollo, sino que también facilita el ajuste fino de los modelos para aplicaciones personalizadas. Ya sea que trabajes en la nube, en dispositivos locales o en servidores on-prem, Llama Stack proporciona un entorno coherente y estandarizado que agiliza el proceso de implementación.

Colaboraciones y Socios Clave

El lanzamiento de Llama 3.2 no habría sido posible sin la colaboración de importantes socios tecnológicos. Empresas como AWS, Databricks, Google Cloud, IBM, Intel y NVIDIA han trabajado junto a Meta para optimizar la implementación de estos modelos. Estas colaboraciones garantizan que los desarrolladores puedan acceder a una infraestructura robusta y fiable para desplegar aplicaciones basadas en IA en diferentes entornos.

Además, Meta ha trabajado estrechamente con Qualcomm y MediaTek para garantizar que los modelos ligeros funcionen de manera eficiente en dispositivos móviles, lo que demuestra un enfoque integral para llevar la IA de vanguardia a más personas en todo el mundo.

Evaluación y Rendimiento de Llama 3.2

Comparativa con Otros Modelos de IA

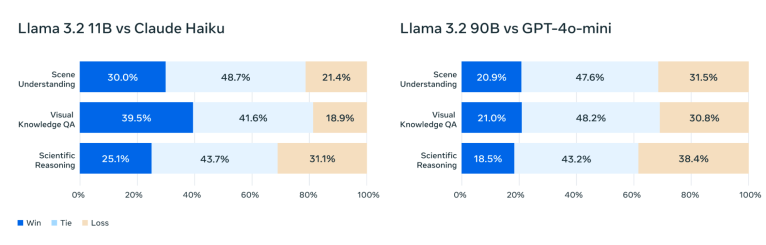

Una de las principales preguntas al evaluar cualquier nuevo modelo de IA es: ¿cómo se compara con la competencia? En este caso, Llama 3.2 ha demostrado estar a la altura de los principales modelos cerrados del mercado, como Claude 3 Haiku y GPT4o-mini, especialmente en tareas de comprensión visual. En pruebas exhaustivas, los modelos de visión de Llama han superado a otros modelos de base en el reconocimiento de imágenes y en tareas de razonamiento visual.

Incluso los modelos ligeros, como el 3B, han demostrado su valía frente a competidores como Gemma 2 y Phi 3.5-mini, destacándose en tareas como el seguimiento de instrucciones y el uso de herramientas. Este alto rendimiento, combinado con la ventaja de ser modelos abiertos, hace de Llama 3.2 una opción muy atractiva para desarrolladores que buscan flexibilidad sin sacrificar capacidad.

Seguridad y Responsabilidad

Meta ha priorizado la seguridad en el desarrollo de Llama 3.2, implementando una serie de salvaguardas diseñadas para garantizar que los modelos sean utilizados de manera responsable. Esto incluye el lanzamiento de Llama Guard 3, una herramienta que filtra solicitudes y respuestas que involucren texto e imágenes para evitar resultados no deseados. Además, Llama 3.2 ha sido entrenado con datos de mitigación de seguridad para asegurarse de que los modelos sean robustos ante intentos de manipulación.

Modelos de Llama 3.2 Disponibles

Llama 3.2 en Hugging Face y Llama.com

Llama 3.2 ya está disponible para su descarga en llama.com y Hugging Face, lo que facilita a los desarrolladores acceder a estos potentes modelos. Además, las versiones optimizadas para dispositivos móviles están disponibles para desarrollarse de inmediato, abriendo un abanico de posibilidades para la creación de aplicaciones en el borde.

El soporte de plataformas como AWS, Google Cloud, y Microsoft Azure garantiza que los desarrolladores puedan desplegar aplicaciones basadas en Llama 3.2 en entornos empresariales a gran escala, mientras que las colaboraciones con Qualcomm y MediaTek aseguran que incluso los dispositivos móviles de última generación puedan beneficiarse de las capacidades avanzadas de IA que ofrece Llama 3.2.

Preguntas Frecuentes

¿Qué es Llama 3.2?

Llama 3.2 es la última versión de los modelos de lenguaje grandes (LLM) de Meta, que incluye modelos ligeros para procesamiento en dispositivos móviles y modelos de visión para tareas avanzadas de comprensión de imágenes.

¿Cómo mejora Llama 3.2 en dispositivos móviles?

Los modelos 1B y 3B están optimizados para operar localmente en dispositivos móviles, lo que garantiza una mayor privacidad y respuestas más rápidas, ya que no dependen de la nube para procesar datos.

¿Qué es Llama Stack?

Llama Stack es un conjunto de herramientas y bibliotecas integradas que simplifican el desarrollo y la personalización de los modelos Llama 3.2, permitiendo su implementación en diversos entornos, como la nube o dispositivos locales.

¿Qué capacidades tienen los modelos de visión de Llama 3.2?

Los modelos de visión de Llama 3.2, como el 11B y el 90B, pueden realizar tareas avanzadas de razonamiento visual, como el análisis de gráficos y mapas, la subtitulación de imágenes y la localización de objetos a partir de descripciones textuales.

¿Cómo se compara Llama 3.2 con otros modelos de IA?

Llama 3.2 ha demostrado ser competitivo con modelos cerrados como Claude 3 Haiku y GPT4o-mini, especialmente en tareas de comprensión visual y razonamiento de imágenes.

¿Dónde puedo descargar Llama 3.2?

Llama 3.2 está disponible para su descarga en llama.com y Hugging Face, y puede desarrollarse en una amplia gama de plataformas tecnológicas, incluidas AWS, Google Cloud y Microsoft Azure.

Conclusión

Llama 3.2 está marcando un nuevo estándar en la evolución de la IA abierta, permitiendo a más desarrolladores y empresas acceder a herramientas avanzadas que anteriormente solo estaban disponibles en entornos cerrados y costosos. Con su capacidad para procesar texto e imágenes, modelos ligeros para dispositivos móviles y un ecosistema robusto de socios tecnológicos, Llama 3.2 está listo para transformar la forma en que se desarrollan y utilizan las aplicaciones de IA. La apertura y la personalización son el futuro, y Llama 3.2 está a la vanguardia de esa revolución.